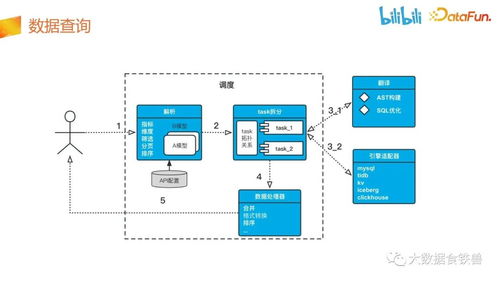

哔哩哔哩数据服务中台建设实践 数据处理服务的架构与挑战

在哔哩哔哩(Bilibili)这一庞大的数字内容生态中,数据是驱动业务增长、优化用户体验和实现精细化运营的核心燃料。为了高效、稳定地管理海量、多元的数据流,哔哩哔哩构建了先进的数据服务中台,其中数据处理服务作为关键一环,扮演着数据“心脏”的角色。本文将探讨哔哩哔哩在数据处理服务中台建设方面的实践与思考。

一、数据处理服务的核心定位与挑战

哔哩哔哩的数据处理服务位于数据中台的核心层,其主要职责是承接来自各业务线(如视频点播、直播、社区互动、电商等)的原始数据,经过清洗、转换、聚合、计算等一系列加工流程,最终产出可供下游分析、应用、算法模型使用的标准化数据资产。其面临的挑战包括:

- 数据规模巨大:每日需处理PB级别的用户行为、视频播放、弹幕评论等数据。

- 实时性要求高:如推荐系统、风控监控等场景需要秒级甚至毫秒级的实时数据处理能力。

- 数据多样性:结构化、半结构化(如JSON日志)、非结构化(如图片、音频元数据)数据并存。

- 业务快速迭代:新业务、新功能层出不穷,数据处理流程需要灵活、可扩展。

二、架构设计与关键技术栈

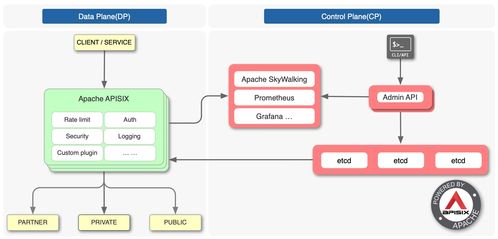

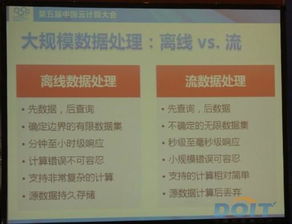

哔哩哔哩的数据处理服务采用了分层、流批一体的混合架构:

- 数据采集与接入层:通过自研的Agent、Logstash、Flume等工具,从业务服务器、客户端、第三方服务等源头实时/离线采集数据,并统一写入Kafka消息队列,作为数据总线。

- 实时计算层:基于Apache Flink构建实时计算引擎。Flink的高吞吐、低延迟特性完美支撑了实时指标计算(如在线人数、热门视频)、实时用户画像更新、实时异常检测等场景。通过Flink SQL和自定义UDF,开发效率大幅提升。

- 批量计算层:基于Apache Spark和Hive构建离线计算体系。负责T+1的批量ETL任务、历史数据回溯、复杂报表生成等。通过YARN或Kubernetes进行资源调度,确保集群资源高效利用。

- 数据存储层:根据数据特性和访问模式,选用不同的存储方案:

- 实时明细数据:存入Apache Druid或ClickHouse,支持高性能OLAP查询。

- 批量结果数据:存入HDFS,并通过Hive Metastore进行元数据管理。

- 维度数据与中间结果:使用MySQL、Redis或HBase。

- 任务调度与运维层:采用Airflow或自研调度平台,管理复杂的依赖关系与定时任务。建设了完善的监控告警体系(如Prometheus+Grafana),对任务健康度、数据质量、资源使用率进行全方位监控。

三、核心实践与优化

- 数据标准化与模型建设:推行统一的数据规范(如OneData模型),建立主题域、业务过程、维度与事实表模型,减少数据冗余与歧义,提升数据一致性。

- 流批一体与Lambda架构演进:积极探索流批融合,如在Flink中实现同一套逻辑同时处理实时流和历史数据,简化架构,降低维护成本。

- 数据质量保障:建立数据血缘追踪、数据稽核(如总量、唯一性、波动性校验)、故障熔断与数据回溯机制,确保数据处理结果的准确性与可靠性。

- 资源优化与成本控制:通过动态资源调整(如Flink Reactive Mode)、计算存储分离、冷热数据分级存储、作业参数调优等手段,在保障SLA的同时有效控制计算与存储成本。

- 平台化与自助服务:将数据处理能力封装成标准化的数据开发平台(DataWorks),提供可视化的ETL开发、任务调试、运维监控界面,赋能业务团队和数据分析师自助进行数据开发,提升整体效率。

四、价值与未来展望

通过构建强大的数据处理服务中台,哔哩哔哩实现了:

- 效率提升:数据开发周期从“天”缩短到“小时”,快速响应业务需求。

- 质量可靠:数据准确性、时效性得到保障,为决策提供可信依据。

- 成本优化:资源利用率提高,基础设施成本得到有效控制。

- 创新赋能:为A/B测试、个性化推荐、智能运营等高级应用提供了坚实的数据基石。

哔哩哔哩的数据处理服务将继续向更智能化、更自动化的方向演进,例如利用机器学习优化任务调度与资源配置,深化实时计算能力以支持更复杂的实时业务场景,并进一步拥抱云原生技术,提升系统的弹性与可观测性,持续支撑哔哩哔哩生态的繁荣发展。

如若转载,请注明出处:http://www.baolaiyaotong.com/product/45.html

更新时间:2026-02-27 07:05:32